纪录一个存储挂载的故障

- 服务器

- 2024-12-28

- 203热度

- 0评论

纪录如下:

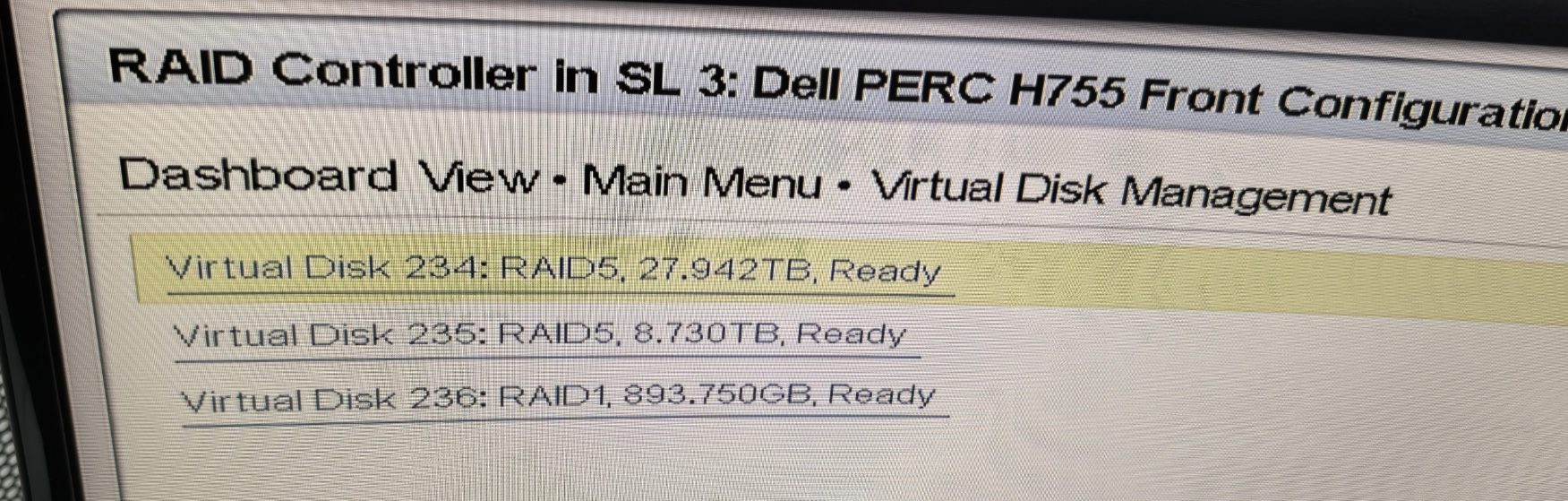

确认原有磁盘Raid卷创建,及系统挂载情况

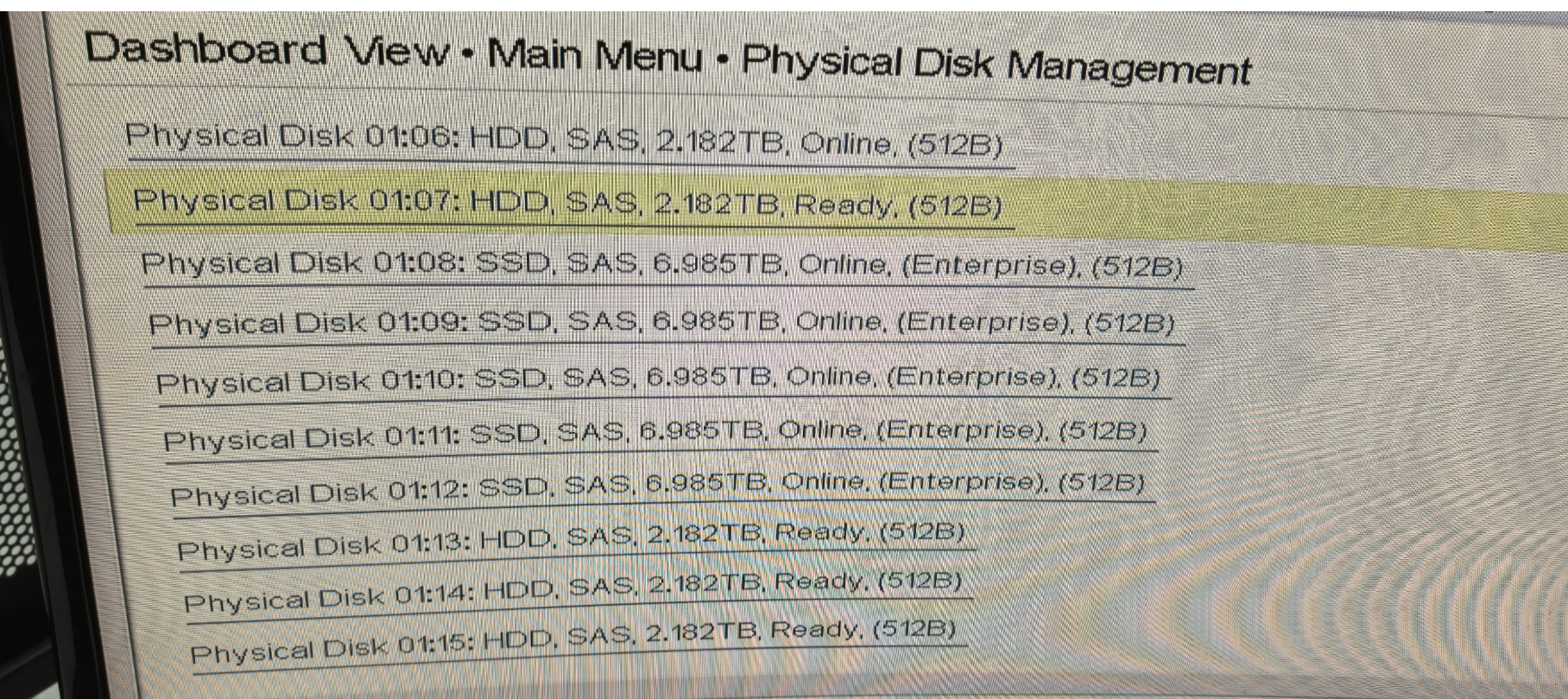

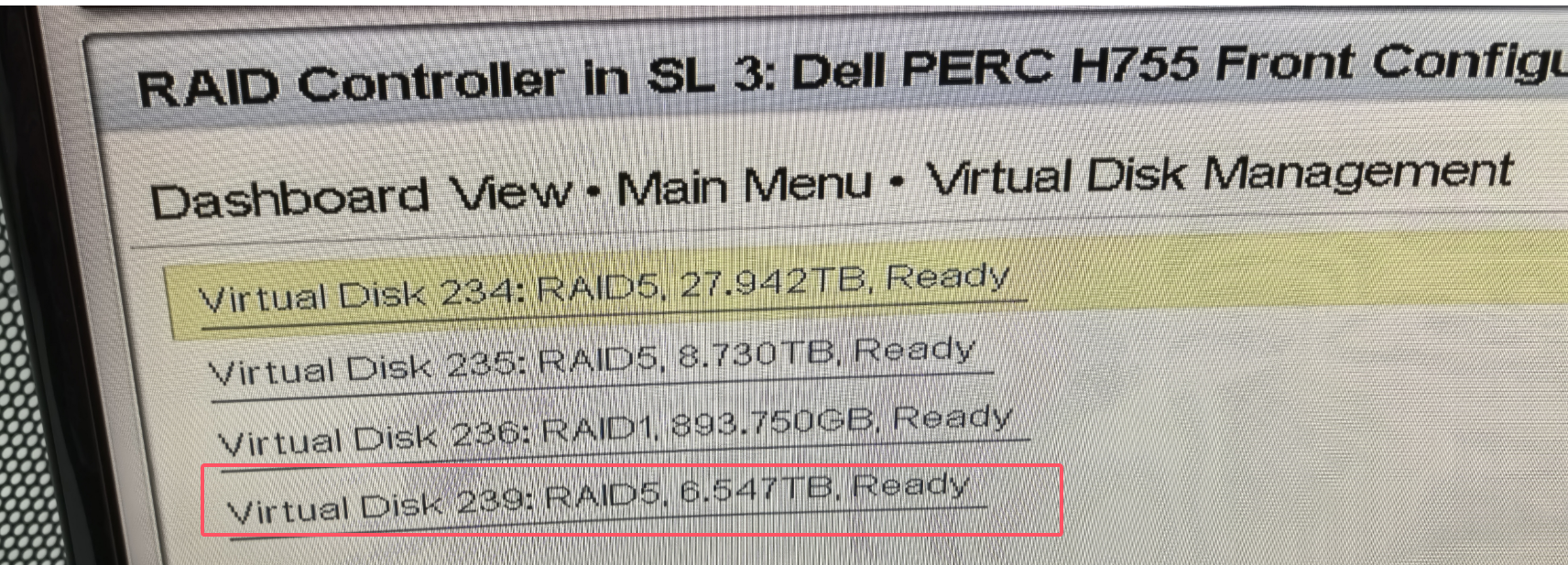

服务器,原有3种不同的硬盘,2个960G SSD做Raid 1安装操作系统,5个2.4T SAS机械盘,做Raid5 做为一个数据存储盘,5个7.68T SSD做Raid5,做为高速数据存储区。

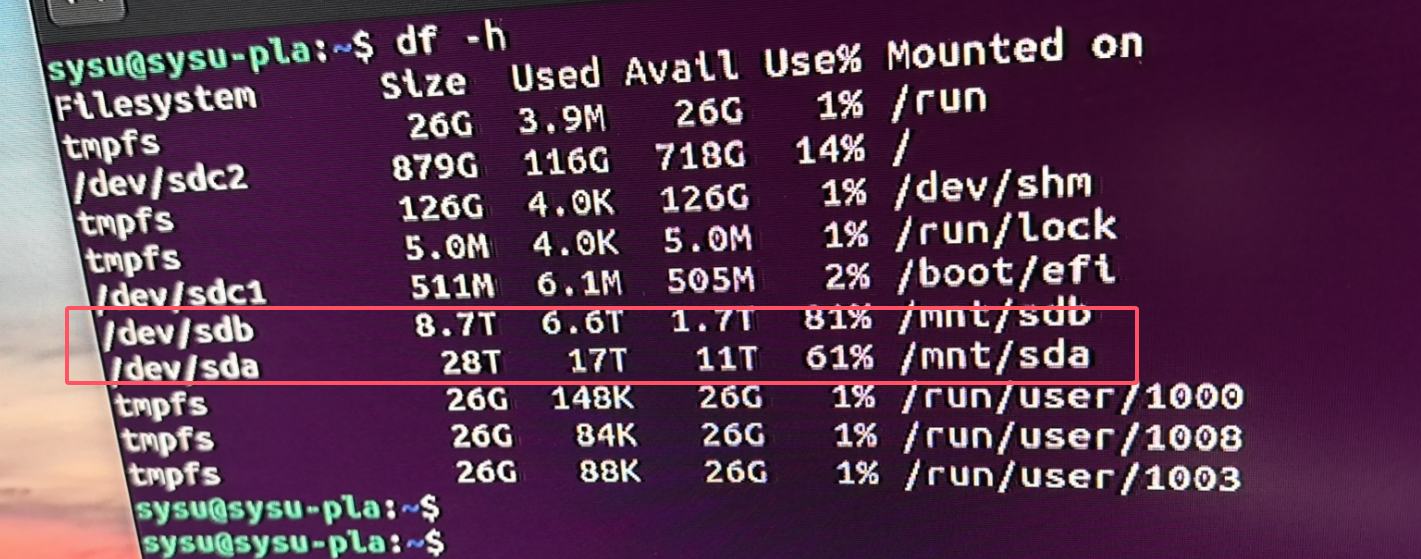

两个Raid5 分别挂载为sda和sdb

安装新硬盘,创建新Raid

将新买的2.4T硬盘接入到服务器,系统正常识别

这里我原打算将这个4颗硬盘,扩容到原有的Raid组。但是老师没有备份数据,担心数据丢失,不允许将这个4个硬盘加入到原有Raid组。

那就创建一个新Raid

重新挂载原来的sdb分区

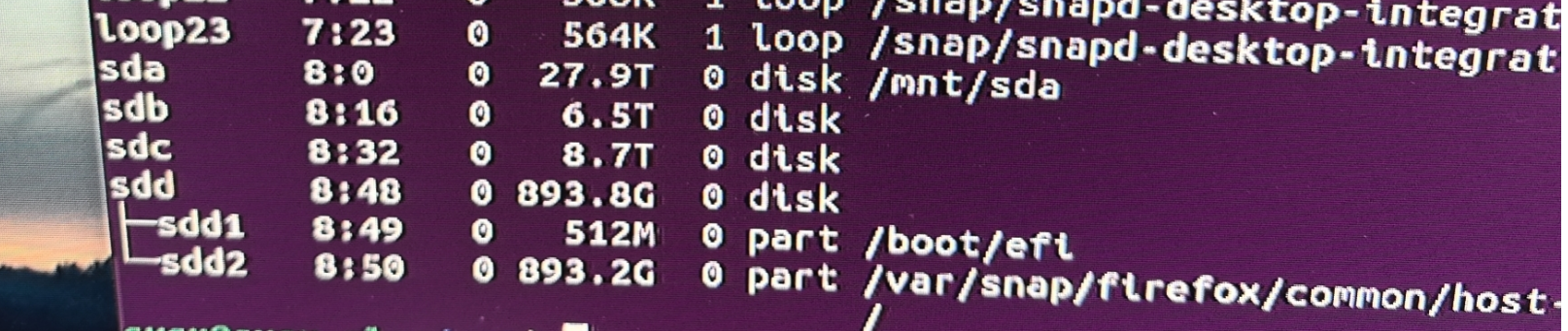

新家的硬盘组建好Raid后,重启服务器,发现原来的sdb 8.7T的分区,并没有正常挂载,导致数据不能访问

老师当时慌了,以为数据丢失了

为什么会出现这样的情况呢?

严谨一点来说UUID的挂载方式更不容易出错,因为sda,sdb等排序是系统根据硬盘的插槽来确定的,和硬盘本身实际上并没有关系,此时若不小心将多块硬盘插错了位置,则可能会挂载到错误的目录下,但UUID是唯一的,可以准确地标识一个分区,因此是更推荐这种方法的。

编辑 /etc/fstab 文件,将原来的挂载方式注释掉

重新用UUDI挂载一遍。

查看UUID的方法也有许多,如

blkid /dev/mapper/cs-root: UUID="124332f7-2cc7-479f-84d2-e8811605774e" BLOCK_SIZE="512" TYPE="xfs"

lsblk -f NAME FSTYPE LABEL UUID MOUNTPOINT sda ├─sda1 xfs f7257152-e114-4576-a376-8dda7fd28409 /boot └─sda2 LVM2_member dJUBpL-fhYG-M0fS-FltG-2fHT-E6er-asQ33D ├─cs-root xfs 124332f7-2cc7-479f-84d2-e8811605774e / ├─cs-swap swap 0879fc04-225e-408a-94e6-a6e141d353f1 [SWAP] └─cs-home xfs 3b27cf54-074d-4a55-8976-72be6188dfed /home

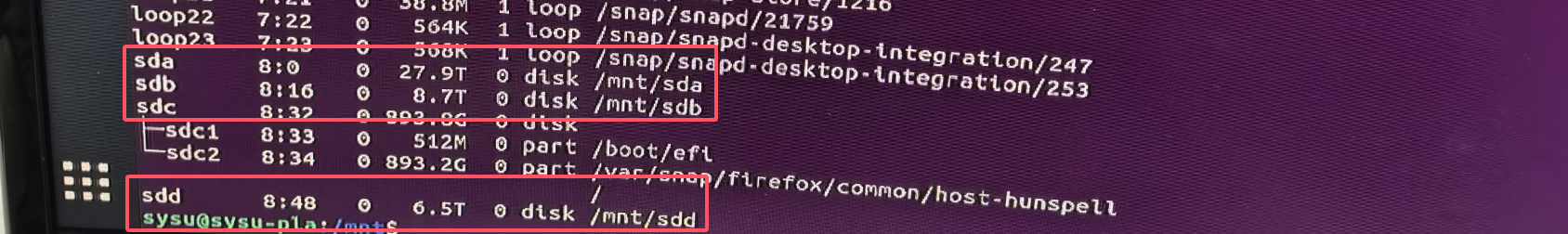

重启服务器,确认挂载是否正确

重启服务器后,查看分区挂载情况,可以看到新加的挂载为sdd 原来的sda和sdb正常挂载,数据访问也正常了。

Linux挂载硬盘详细操作步骤,参考如下链接